Wie funktioniert eine Suchmaschine?

Copyright © Shutterstock/mangpor2004

Inhaltsverzeichnis

1. Wie funktioniert eine Suchmaschine?

Das Internet hat die Welt verändert, wie zuvor wohl nur andere historische Erfindungen wie die Nutzbarkeit von Strom oder Kommunikation via Telefon, Rundfunk und Fernsehen. Dieser enorme Erfolg wäre niemals möglich gewesen ohne Suchmaschinen. Erst Suchmaschinen ermöglichen es, für den User wichtige Webseiten im Word Wide Web zu finden.

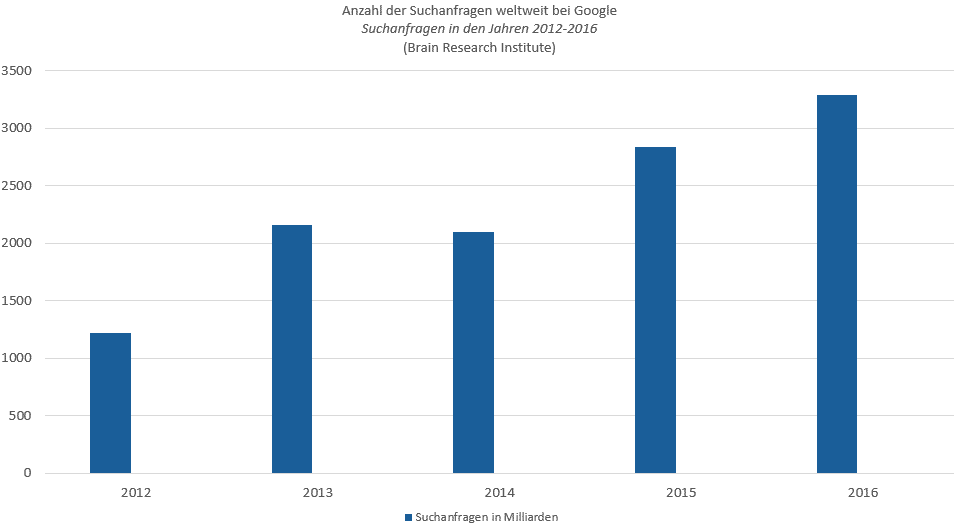

Die Suchanfragen steigen, bis auf wenige Ausnahmen, kontinuierlich an

Laut Statista wurden im Jahr 2000 nur bei Google alleine 9,24 Milliarden Suchanfragen weltweit durchgeführt. 2016 waren es bereits 3.293 Milliarden Suchanfragen weltweit, davon alleine im Dezember 2016 6,6 Milliarden.Doch was macht den Erfolg einer Suchmaschine aus? Um diese Frage beantworten zu können, ist es zunächst wichtig zu verstehen: Wie funktioniert eine Suchmaschine?

2. Die verschiedenen Arten von Suchmaschinen

Auf die Frage, welche Suchmaschine jemand nutzt, kamen vor wenigen Jahren noch unterschiedliche Antworten mit den unterschiedlichsten Anbietern. Heute steht “Suchmaschine” schon fast synonym für Google. Dabei gibt es wesentlich mehr Suchmaschinen. Doch nicht nur die Anzahl an Search Engines ist vielfältig. Ebenso die Technik, die von den verschiedenen Anbietern genutzt wird. Wie funktioniert eine Suchmaschine – das hängt maßgeblich von diesen Techniken ab. Daher zunächst eine Übersicht über die wichtigsten Arten von Suchmaschinen:

- Meta-Suchmaschinen

- Volltext-Suchmaschinen

- Webverzeichnisse

3. Die Meta-Suchmaschine

Bei Meta-Suchmaschinen können in der Regel keine eigenen Seiten direkt eingetragen werden. Vielmehr nutzen diese andere Suchmaschinen als Suchquelle. Daher besitzen diese Suchmaschinen zumeist auch keine eigene Datenbank, in welcher die möglichen Seiten und Suchergebnisse abgelegt sind. Die Suchergebnisse in Suchmaschinen sind wie Metadaten angelegt. Daher werden diese Suchmaschinen auch als Meta-Suchmaschinen bezeichnet.

Die Inhalte, die sie im Frontend anderer Suchmaschinen finden, werden dem Suchenden als Ergebnis angezeigt. Daher stimmen die Snippets mit denen der Suchmaschinen überein, woher sie ihre Daten beziehen. Die “Anmeldung” einer eigenen Website erfolgt über den Umweg, dass diese Seite in einer oder mehreren Suchmaschinen gelistet sein muss, von der die Daten bezogen werden. Die Bedeutung von Meta-Suchmaschinen ist heute eher untergeordnet für die breite Masse der Internet-User. WebCrawler war die erste Meta-Suchmaschine aus den USA, heute und in Europa die wichtigste ihrer Art ist MetaGer.

Die Suchergebnisse können nach unterschiedlichen Vorgaben gefiltert werden. Beispielsweise, dass nur solche Ergebnisse präsentiert werden, die in verschiedenen anderen Suchmaschinen innerhalb eines Top-Rankings liegen. Der Nachteil der in den 1990ern aufgekommenen Meta-Suchmaschinen ist der Zeitaufwand. User müssen spürbar länger auf Suchergebnisse warten.

4. Die Volltext-Suchmaschine

Wie funktioniert eine Suchmaschine – das ist besonders bei der Volltext-Suchmaschine interessant, da diese führend sind. Die Volltext-Suchmaschine arbeitet über sogenannte Bots oder Spiders. Das sind kleine Programme, die den Text von bekannten Webseiten durchsuchen. Dabei folgen die Bots auch Links auf den Seiten. Das gilt sowohl für interne als auch externe Links. Wenngleich einige Betreiber solcher Suchmaschinen vergewissern, dass sie solchen Links bei entsprechenden Befehlen (rel=”follow”, rel=”nofollow”) nicht folgen, ist nicht auszuschließen, dass sie trotzdem diesen Links folgen und diese zumindest analysieren.

Google empfiehlt daher die Anwendung einer htaccess.. So können einzelne Dateien und Verzeichnisse vor Zugriffen vom Crawler geschützt werden. Trotz alledem wird beim Auschluss durch htaccess eine Seite grundsätzlich weiter indexiert, allerdings werden bestimmte Daten hierbei herausgenommen, wie beispielsweise die Metadaten.

So können auch Bereiche einer Webseite grundsätzlich gegen Crawler-Zugriffe geschützt werden. Wie oft nun ein Bot eine Seite besucht, hängt von den Aktivitäten ab. Verändern sich Textinhalte auf einer Webseite über einen langen Zeitraum nicht, kommen die Bots seltener vorbei. Bei Seiten, die sehr viel neuen Content generieren, kann die Indizierung dagegen beinahe in Echtzeit erfolgen.

Nachdem der Robot oder die Spider eine Seite besucht hat, wird deren Inhalt von einem Indexierer nochmals bearbeitet und in eine eigene Datenbank eingetragen – die betreffende Webseite ist nun indexiert bzw. im Suchmaschinenindex aufgenommen. Über das Frontend der Suchmaschine eingetragene Suchbegriffe werden nun an die Datenbank weitergeleitet. Klickt der Sucher eine Seite in den SERPs (Suchmaschinen-Suchergebnisseseiten von Search Engie Ranking Pages), erfolgt eine Weiterleitung zur betreffenden Seite.

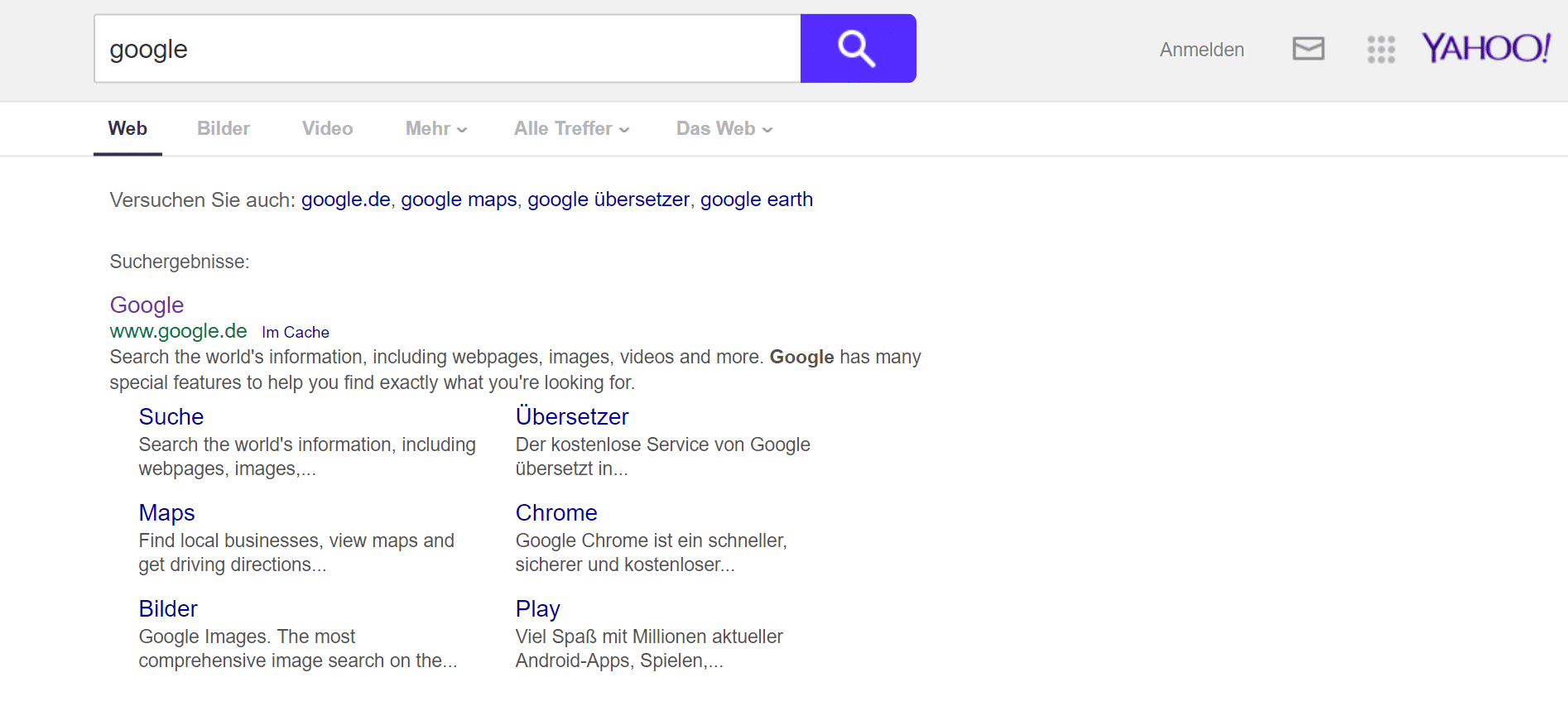

Die wohl bekannteste Volltext-Suchmaschine ist Google, gefolgt von Yahoo und Bing (Microsoft). Wobei zu erwähnen ist, dass Yahoo und Bing mittlerweile zusammen gehören, jeweils aber noch eigenständige Portale betreiben. Früher war Google die Suchmaschine im Webverzeichnis von Yahoo, bevor sie sich als eigenständige und erfolgreichste Suchmaschine etablierte. Der Marktanteil von Google liegt international und national zwischen 80 und 90 Prozent. Daneben gibt es noch zahlreiche Themen-Suchmaschinen. Diese fokussieren ausschließlich ein Themenfeld und nicht alle Websites.

5. Webverzeichnis

Bei Webverzeichnissen handelt es sich streng genommen nicht um Suchmaschinen, daher ist auch die Frage, wie funktioniert eine Suchmaschine, nicht ganz zutreffend. Jedoch waren Suchmaschine und Webverzeichnis in den Anfangszeiten des Internets eng miteinander verknüpft. Diese werden folglich nicht maschinell, also automatisiert, erstellt.

Vielmehr gibt es menschliche Redakteure, die jeden Eintrag in ein Webverzeichnis manuell überprüfen. Bei vielen Millionen Websites lässt sich gut vorstellen, wie aufwendig das ist – was letztlich auch eine Kostenfrage darstellt. Ihre wirklich große Zeit hatte das Internetverzeichnis oder die Web Directory in den 1990ern mit Yahoo. Damals war Yahaoo ein sehr erfolgreiches Webverzeichnis (Do you Yahoo?) und wurde von der zuvor integrierten Suchmaschine Google verdrängt.

Es folgte eine Zeit, in der Directories nur noch für die Suchmaschinenoptimierung genutzt wurden, da Suchmaschinen solchen eingehenden Links lange Zeit ein hohes Gewicht zuteil werden ließ. Das wohl bekannteste und populärste Webverzeichnis war DMoz. Aufgrund der hohen Bearbeitungszeit, können Eintragungen Monate beanspruchen oder es kommt erst gar nicht zu einem Eintrag. Der Sinn einer solchen Eintragung ist strittig aus der Sicht von Suchmaschinenoptimierung (SEO). Besucherzahlen von Web Directories fallen nicht ins Gewicht.

6. Crawling und Indexierung

Wie bereits unter “Arten von Suchmaschinen” geschrieben, gibt es unterschiedliche Techniken, die für Suchmaschinen angewandt werden. Nach der angewandten Technik funktioniert eine Suchmaschinegänzlich unterschiedlich. Hier ist deshalb wieder nach den Arten der Suchmaschinen zu unterscheiden:

- Volltext-Suchmaschinen

- Meta-Suchmaschinen

- Web Directories (Internetverzeichnisse)

Funktioniert eine Suchmaschine über die Indexierung, ist zunächst dessen Definition entscheidend. Der Index ist eine Datenbank, die intern von einer Suchmaschine betrieben wird. Alle Anfragen bei der Keyword-Suche laufen also nicht “hinaus” ins World Wide Web. Vielmehr werden Spider oder Bots, kleine Programme, entsandt, die sich über Verlinkungen auf Websites weiterarbeiten. Abhängig von den eingestellten Parametern und Filtern, die wir unter “Ranking” näher beschreiben, erfolgt bei diesem Crawling eine Indexierung oder wird auch verweigert.

6.1 Crawling und Indexierung bei Volltext-Suchmaschinen

Insbesondere Volltext-Suchmaschinen wenden diese Technik der Indexierung an. Die Frage, wie funktioniert eine Suchmaschine, ist daher gerade hier besonders wichtig. Unter welchen Voraussetzungen eine Indexierung erfolgreich ist, hängt dabei von den Kriterien der verschiedenen Suchmaschinen ab. Auch das Crawling erfolgt unterschiedlich. Was dabei zu beachten ist, kann in den Richtlinien zur Indexierung in den verschiedenen Suchmaschinen nachgelesen werden. Hilfreich sind dabei spezielle Sitemaps, die nicht für das menschliche Auge gedacht sind. Diese XML-Sitesmaps sind so aufgebaut, dass sie für die Bots gut zu verfolgen und verwerten sind.

6.2 Crawling bei Meta-Suchmaschinen

Meta-Suchmaschinen verwalten keine internen Index-Datenbanken. Folglich kann auch kein Index erstellt werden. Stattdessen läuft der Crawler über die SERPs anderer Suchmaschinen und verwertet deren Suchergebnisse. Daher gibt es einen spürbaren Zeitunterschied zwischen Suchanfrage und Suchergebnis. Letztendlich konnten sich diese Suchmaschinen aus dieser Problematik heraus nicht durchsetzen. Das Verfahren zum eigenen Ranking muss nämlich während der Suchanfrage ebenfalls noch erfolgen und ist ebenfalls für die Zeitverzögerung verantwortlich.

6.3 Crawling und Indexierung bei Web Directories

Bei Web Verzeichnissen gibt es streng genommen kein Crawling. Vielmehr erfolgt eine redaktionelle Prüfung durch einen Menschen. Sehr wohl gibt es aber eine Datenbank, in der akzeptierte Webseiten aufgenommen, also indexiert, werden.

Das Liefern von Antworten

Wie funktioniert eine Suchmaschine beim Liefern von Antworten, lässt sich zunächst schnell beantworten: die Suchergebnisse werden aus dem erstellten Index geliefert. Allerdings ist es ein komplexer Vorgang. Darüber hinaus liefern Suchmaschinen wie Google unterschiedliche Typen von Antworten.

Anfangs erfolgte das Liefern von Antworten in Suchmaschinen noch nach sehr einfachen Techniken. Es wurde überprüft, wie häufig das Suchwort im Text (Body) einer Webseite auftauchte und ob es darüber hinaus in den nicht sichtbaren Meta Tags (meta keywords) aufgeführt wurde. Davon kamen die Suchmaschinen sehr schnell ab, da es zu viel Missbrauch führte.

Meta Tags haben in den letzten Jahren massiv an Bedeutung verloren. Auch die Keyword-Dichte wird inzwischen anders bewertet (mehr zu diesen Punkten unter “Ranking). Stattdessen setzt beispielsweise Google immer mehr aus strukturierte Daten bzw. Markups. Damit können zusätzlich Rich Snippets optimiert werden. Geeignete Formate sind Json-LD, microdata oder RDFa.

Diese Markups gewinnen an Bedeutung, denn sie ermöglichen der Suchmaschine beispielsweise die Unterscheidung von “Schwarz” als Autorennamen oder Farbe. Aber auch zeitlich begrenzte Events, Bilder und Videos, die von den Bots nicht “gelesen” werden können, lassen sich so mit weiterführenden Informationen ausstatten, die dann Teil der Antwort und/oder Relevanz werden.

Die gelieferten Antworten setzen sich bei Google aus dem Titel und einer Beschreibung, also dem Snippet, zusammen. Bislang war die Länge der Beschreibung bei Google begrenzt, inzwischen experimentiert die Suchmaschine mit mehr erlaubten Zeichen, die deutlich längere Beschreibungen gestatten.

Das Liefern der Antworten erfolgt bei Google zudem nach unterschiedlichen Kriterien. Es kann eine bezahlte Antwort (sponsored – AdWords) erscheinen. Dann gibt es bis zu fünf Rich Snippets. Das sind besonders ausführliche Snippets, die je nach Vorgaben mit Google Maps und einem Bewertungssystem verbunden sein können. Erst dann folgen die Suchergebnisse in den gewöhnlichen Snippets.

Relevant ist wiederum nur die erste Suchergebnisseite. Mit viel Glück durchsuchen User noch die ersten drei Ergebnisseiten der SERPs, doch bereits das zweite Suchergebnis auf der ersten Seite verzeichnet signifikant weniger Traffic (Click-throughs). Bei einer Suchmaschine wie Google muss zudem nach der landesspezifischen Suchmaschinenseite sowie der Local Search unterschieden werden. Die Suchergebnisse von google.com werden in den meisten Fällen deutlich von denen auf google.de abweichen. Aber auch die Spracheinstellungen und der Standort (Geo-Targeting) beeinflussen die Suchergebnisse.

7. Das Ranking

Damit kommen wir auch schon zum Ranking. Wie eine Suchmaschine funktioniert, dafür ist das Ranking das Herzstück jeder Suchmaschine. Denn wie das Ranking erfolgt, beeinflusst die Qualität der gelieferten Ergebnisse maßgeblich. Linkspam und Kommentarspam, wie ihn im Prinzip jeder Internetuser kennt, ist eine Folge der Versuche, die Qualität zu verbessern.

Wie eine Suchmaschine funktioniert oder besser gesagt lange Zeit funktionierte, hatte wegen des damit einhergehenden Spams sicherlich für den einen oder anderen verärgerten Nutzer zur Folge. Dabei ist zu erwähnen, dass das Ranking auf dem ersten Platz in den SERPs in einer populären Suchmaschine wie Google Gewinne in Millionenhöhe ausmachen kann.

So war eine grundlegende Idee, dass externe Links (Backlinks) bedeuten, dass der Seitenbetreiber, auf dem der Link gesetzt wurde, die verlinkte Seite als wichtig empfinden muss. Über Jahre war es dann so, dass die Anzahl der Backlinks über die Position in den SERPs entschied.

Wenn aber keine wertvollen und für den Suchenden hochwertigen Ergebnisse mehr präsentiert werden können, wird dieser eine andere Suchmaschine wählen. Für Google war es daher existenziell, diesen Missstand zu beheben. Dazu wird der Algorithmus der Suchmaschine, der für das Ranking von Webseiten verantwortlich ist, stets verändert. Mit den Algorithmus-Updates Farmer und dann Penguin (grundsätzlich) und Venice bei der Local Search wurde der Grundstein für deutlich bessere Suchergebnisse gelegt. Zu den Updates finden Sie einen Artikel im SEO Handbuch der dieses Thema noch genauer behandelt.

Die Parameter und Filter, die Suchmaschinen dazu einsetzen, sind ein streng gehütetes Geheimnis. Dennoch kommen immer wieder vermeintliche Parameter und Filter ans Licht. Das verbreitet sich in SEO-Foren, es beginnt weltweit wieder ein massives Manipulieren, bis Google das erkennt und ändert. Entsprechend wird SEO (Suchmaschinenoptimierung) in White-Hat-SEO (nach den Richtlinien der betreffenden Suchmaschine) Grey-Hat-SEO (in einer Grauzone, also bereits problematisch) und Black-Hat-SEO unterteilt.

Funktioniert eine Suchmaschine nicht richtig und liefert viele minderwertige Suchergebnisse, wird sie weniger häufig genutzt werden. Besonders, wenn viele Black-Hat-Techniken funktionieren würden. Schon eine zu hohe Keyword-Dichte (Density) kann fatale Folgen haben.

Letztgenanntes Black Hat SEO beeinflusst das Ranking ist so massiv, dass betreffende Seiten abgestraft werden können und aus dem Index dauerhaft entfernt werden können, um dessen Qualität sicherzustellen. Daher sollten bereits genutzte Domains immer geprüft werden vor dem Kauf.

Zur Unterstützung, wie Google eine Webseite betrachtet, bietet das Unternehmen die Google Search Console an. Nach der Analyse dort können dann von Google gebilligte Optimierungsmaßnahmen durchgeführt werden. Sicher ist in jedem Fall, dass sich die Parameter für das Ranking fortlaufend ändern. Laut Google gibt es mehr als 300 verschiedene Faktoren.

8. Fazit

Lange Zeit war die klassische Suchmaschine die einzige Möglichkeit, überhaupt andere, für den User wichtige Websites zu finden. Dazu kamen in den letzten Jahren viele Social Media Angebote. Als diese Social Media aufkamen, wurde von einigen sogar das Ende der Suchmaschinen vorhergesagt. Nichts davon ist eingetroffen. Im Gegenteil stellen Suchmaschinen auch heute noch unter Beweis, dass sie das mit Abstand wichtigste Instrument zur gezielten Suche von Web Inhalten sind. Funktioniert eine Suchmaschine so gut wie inzwischen Google, ist ihr Erhalt sicher.

Über die letzten Jahre hat sich vor allem die Volltext-Suchmaschine und mir ihr insbesondere Google bestens etabliert. Zwar wird dem Internetriesen nicht ganz zu Unrecht immer wieder eine Monopolstellung vorgeworfen, die es natürlich für eigene Interessen ausnützt. Dennoch bleiben nahezu alle User bei dieser Suchmaschine, weil sie eben die hochwertigsten Suchergebnisse liefert.

Für Internet-Nutzer, die gezielt nach Inhalten suchen, sind Suchmaschinen immer noch das wichtigste Tool. Für diejenigen, die Internet-Marketing betreiben, ist die Optimierung eigener Websites für die großen Suchmaschinen oftmals entscheidend über den Erfolg oder Misserfolg eines kommerziellen Online-Projekts.

Für beide Gruppen von Nutzern ist es wichtig zu wissen, wie eine Suchmaschine funktioniert. Denn nur dann kann eine solche wirklich effizient und mit bestmöglichem Ergebnis genutzt werden. Bei der Frage, wie funktioniert eine Suchmaschine, lässt sich zudem feststellen, dass diese einen fortlaufenden Entwicklungsprozess durchlaufen. Die Suchergebnisse werden immer hochwertiger und für den Suchenden treffender. Der Trend wird wohl dahin gehen, dass Machine Learning bereits ein vollzogener Schritt Richtung Zukunft ist und in nicht allzu ferner Zukunft die Technologie einer KI (AI), also einer künstlichen Intelligenz, nahekommen wird.

Die OSG Performance Suite

- SEO: Keyword-Tool, Content Suite, Backlink Suite, SEO Technik-Crawler, Local SEO

- SEA-Tool

- Brand Protection

- Security-Crawler

- Pagespeed-Tool & Uptime Monitoring

- Schnittstellen zu Google Ads, Google Search Console, Google Analytics Bing Webmaster Tools u. a.

- Projektmanagement

- inkl. App und Push Notifications

- und viele weitere Features

Keine Kommentare vorhanden